编译:高杰

同样是嘴角上扬,

发自内心的“真笑”&应付社交的“假笑”

有着质感差异,

我们凭直觉便能分辨,

却鲜少有人深究:

大脑究竟是如何操控面部肌肉,

让真笑灵动自然,假笑却难掩刻意?

近日,来自洛克菲勒大学、希伯来大学等机构的研究团队在《Science》发表的一项突破性研究发现,无论是真诚的情绪微笑,还是刻意的社交假笑,面部表情并非如传统认知那般由大脑不同区域各自支配,而是都遵循着一套统一的神经逻辑。

表情神经“分工”假说被打破

传统神经科学认为,人类面部表情由两个独立系统支配:大脑外侧皮质负责刻意的自愿动作,比如应付社交场合的假笑、说话时的口型变化;内侧皮质则主导情绪驱动的表情,比如听到笑话时开怀的大笑。这种划分部分源于对中风患者的观察,有些患者能自然流露微笑,却无法做出礼貌性假笑。

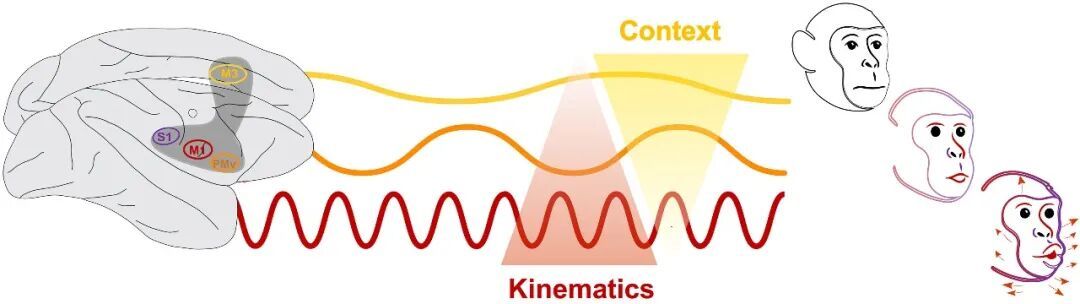

但这项新研究选取非人灵长类动物猕猴作为研究对象,采用功能性磁共振成像(fMRI)和多通道阵列记录的创新技术,精准定位并同步监测了4个关键皮质区域的神经元活动——初级运动皮质(M1)、腹侧前运动皮质(PMv)、扣带回运动皮质(M3)和初级躯体感觉皮质(S1)。

实验中,研究人员通过直接互动、同类视频、数字虚拟形象等多种动态刺激,诱导动物做出威胁性表情(露齿)、社交示好(咂嘴)非社交动作(咀嚼)等不同类型的面部行为,同时持续追踪面部肌肉运动轨迹与神经元放电信号。

结果令人意外:所有4个皮质区域都参与了自愿性和情绪性面部手势的编码,每个区域里既存在能广泛响应多种表情的“通用神经元”,也有专门针对特定手势的“专属神经元”。这意味着,大脑生成表情的模式并非“分而治之”,而是一场全区域协同作战的“交响乐”。

皮质层级的“协同”:动态+稳定

更精妙的是,这个协同网络存在着清晰的“时间动态层级”,如同一场编排缜密的音乐二重奏——外侧区域与内侧区域各司其职,却又无缝衔接。

大脑外侧区域(M1和S1)采用“动态编码”策略:神经元活动以毫秒为单位飞速变化,实时驱动面部肌肉的瞬时运动,保证了表情的灵活性和精准性。比如猕猴做出威胁露齿动作时,M1区会先激活对应肌肉让嘴角后扯,再同步调控咬肌收缩,确保表情流畅自然。

而内侧和前部区域(M3和PMv)则采用“稳定编码”策略:在面部动作发起前,这些区域的神经元就已启动独特的活动模式,且在整个动作过程中保持稳定,专门整合社交背景、内在情绪、视觉反馈等信息,为表情定下“社交基调”。

研究还发现:动作发生前,这些皮质区域就已呈现出清晰可辨的神经活动轨迹,不同表情对应的“神经密码”互不重叠。这表明,我们的每一个表情都不是被动反射,而是大脑提前规划——就像演员登台前的彩排,大脑早已在神经层面完成了表情的预演。

这也解释了“真笑”与“假笑”的差异:真笑时稳定编码区域同步整合情绪信号,动态编码精准驱动眼周、嘴角肌肉协同运动;假笑仅靠意识调控动态编码,缺少稳定情绪信号的加持,肌肉配合便显得生硬。

这套“动态-稳定”的皮质层级设计,是灵长类动物适应复杂社交环境的智慧结晶,不仅改写了我们对表情神经机制的固有认知,更蕴含着重要的临床价值。

对于中风、脑损伤后出现面部瘫痪的患者,这项研究为脑机接口技术的升级指明了新方向:未来无需局限于单一运动区域的修复,而是可通过同步解码动态运动与稳定情绪信号,开发更精准的辅助设备,帮助患者恢复自然表情,重建顺畅的社交。

数据图及参考来源:

https://www.science.org/doi/10.1126/science.aea0890

本文封面图及文内图片均来自包图网(获授权使用),转载可能引起版权纠纷。