算力,不只是大模型时代的“引擎”。从数据中心到行业落地,谁能让AI的潜力真正流动起来,谁就有机会点亮未来。近日,在“大模型技术应用落地系列沙龙”首场活动上,四位来自基础设施、绿色能效、智能运维到算力服务的嘉宾,用真实的场景与难题,把算力创新的“隐秘赛道”拉到了聚光灯下。无论是电费账单,还是用户需求的细微变化,每一环都在考验着行业的耐心与想象力。

为深化上海国际创新中心建设,发挥青年科学家的创新活力,打造“小精专”的交流平台,上海科学技术交流中心举办“智汇申动”系列沙龙,分为围绕空天信息感知处理技术、元宇宙技术应用以及大模型技术应用落地三大主题,邀请来自高校和企业的专家学者,围绕产业落地的核心环节开展交流研讨,旨在进一步促进跨地域、跨学科、跨领域的融合创新,打造技术交流的产学研跨界融合平台。

本场沙龙为“大模型技术应用落地系列”首场活动,由上海工程技术大学副教授黄勃担任主席,召集青年学者、行业专家,聚焦“算力供给与应用边界”主题,探讨算力供给侧大模型实际应用。

能源的焦虑、效率的拐点:

谁能守住AI的底座?

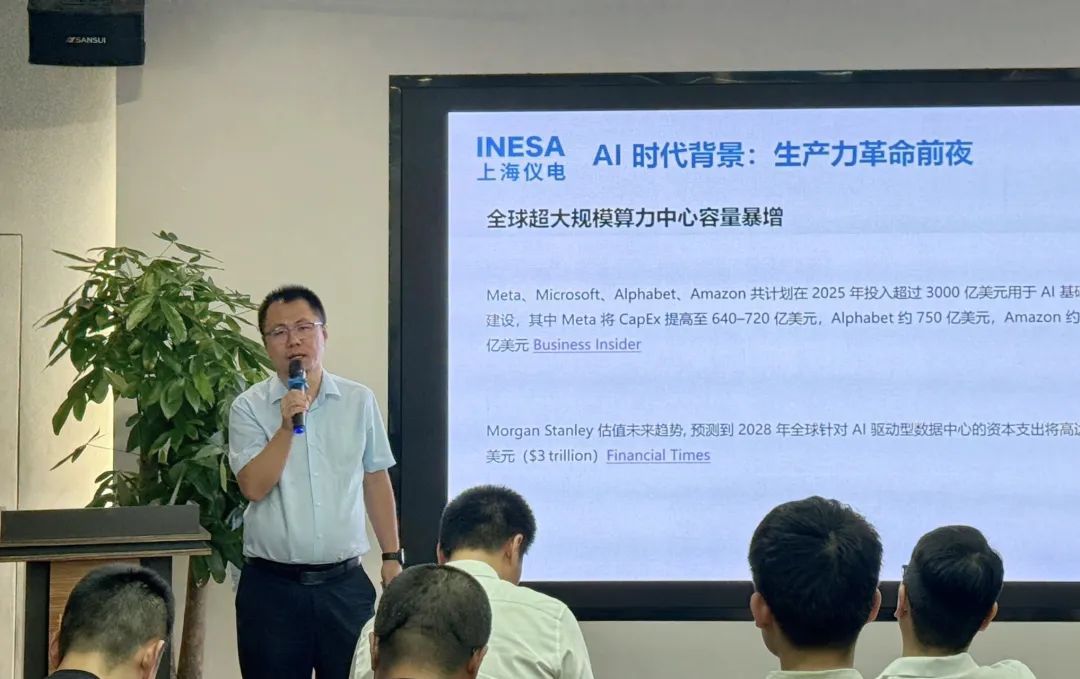

“给服务器供电,远比想象中复杂。”临港算力(上海)科技有限公司市场经理曹春首先抛出一组真实的数据。PUE、能效比、千万电费,数据中心的能耗压力正在与模型规模同步升级。绿色能效,不再是“加分项”,而成了整个AI产业链的生命线。曹春介绍,临港算力团队在多方面研究升级,确保新型算力设备的稳定运营;然后算力调度,在上海与湖北之间三分钟内切换任务,“一是响应国家电网的降峰,第二是我们在探索和其他区域智算中心的协同。节省的不只是电费,更是一座城市面向未来的底气。”

基础设施的转型,直接影响着算力能不能真正“普惠”。上海智能算力科技有限公司CTO张宏洲的关注点则是:如何打通算力服务的“最后一公里”。“我们不是小规模供给,万台集群是常态,但到了后训练、推理等阶段,算力需求碎片化、弹性化,怎么让资源快速匹配到不同用户?这成了行业新挑战。”

张宏洲认为,算力使用门槛高、成本高,企业“找不到”合适算力,“用不起”高性能集群,是阻碍创新普及的两座大山。他直言,团队不得不在产品与平台上进行多次技术演进——“推理的请求体积波动极大,服务要敏捷又要降本”。正因如此,国产算力产品的崛起与高效资源调度,已成为行业竞逐的核心赛点。张宏洲总结:“基础设施供给已进入AI应用的第二阶段,即从专业机构迈向专业用户,最终走进大众,让算力成为真正的社会基础资源。”

从电力的细节,到算力平台的迭代,每一项创新、每一个“降本”动作,都是为大模型落地扫清前路。正如曹春和张宏洲反复强调的,基础设施的变革,不只关系到一家公司、一台服务器,更直接决定了整个AI生态链的上限。

应用落地的闭环:

从行业难题到智能运维的“飞轮”

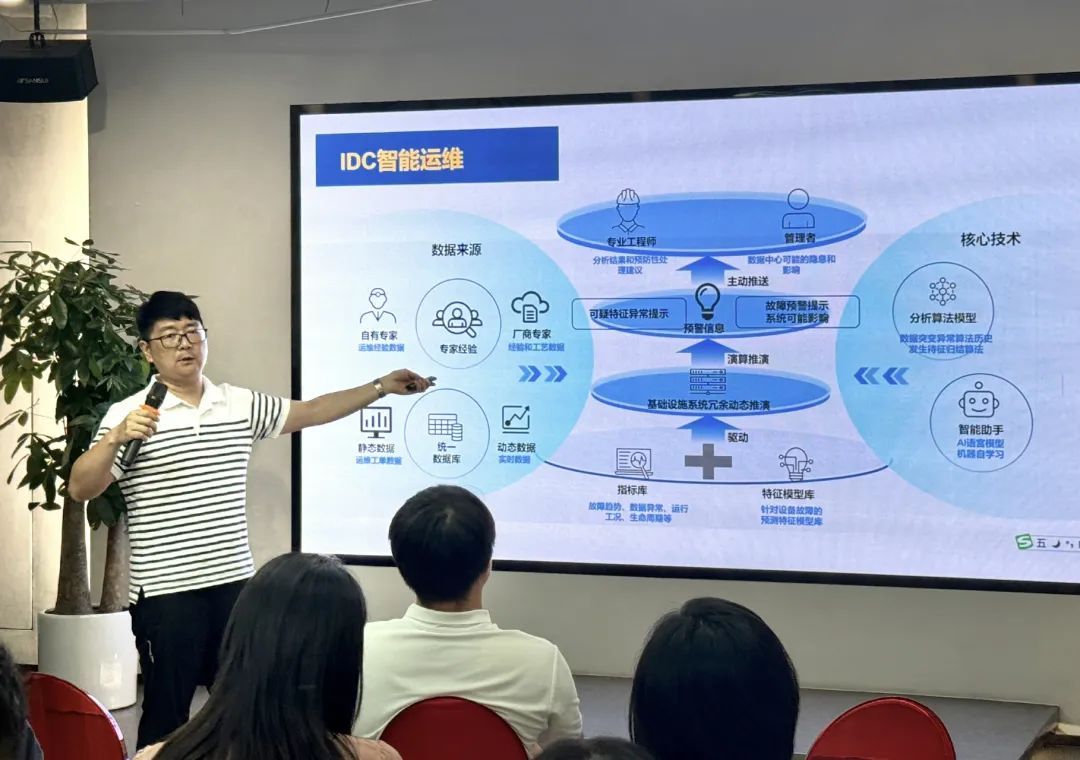

当基础打稳,算力如何真正“解锁”产业价值?这个问题,几乎贯穿了武星、余啸两位嘉宾的全部分享。上海大学教授武星多年深耕数据中心智能运维,他的切身体会是:数据中心“智慧升级”的关键,是让专业数据与行业知识结合起来,“让数据说话”。他举例说,在金融、交易所等场景,通过高精度感知和建模,可以把原本几天的运维工作压缩到几分钟。自动健康评估、异常预警不再只是“黑盒”,而是专业知识与AI模型的“组队作战”。

但武星也指出,通用大模型带来的“幻觉”问题,让行业用户对结果的精准性要求更高。于是,小模型加规则引擎成为目前工程落地的主流,“数据要治理,知识要归纳,模型要可控。只有这样,智能运维才能帮工程师做出真正可靠的决策。”

浙江大学专职研究员余啸则补充,AI大模型在软件工程、自动化开发等领域确实已经广泛应用,但距离完全端到端自动化,还有很远的路要走。他坦言,大模型目前更适合协助、补全而不是全面替代,“必须让团队参与、理解、修正模型结果,才能保证工程的可交付性和可靠性。”正因如此,智能运维与行业应用的进步,本质上是数据、知识与人的三重共振。

两位专家的观点,也得到了张宏洲的现实印证。作为算力基础设施的“操盘手”,他强调,只有把用户实际需求、数据流转与高效算力调度无缝衔接,AI才能变成可见、可用的生产力。“我们平台收集各种高质量语料,尤其是行业、私域数据,让开发者和企业有足够的资源和动力实现模型的闭环迭代。”

企业及专家观点不代表官方立场

作者:蓝悦

↓分享

↓点赞

↓在看